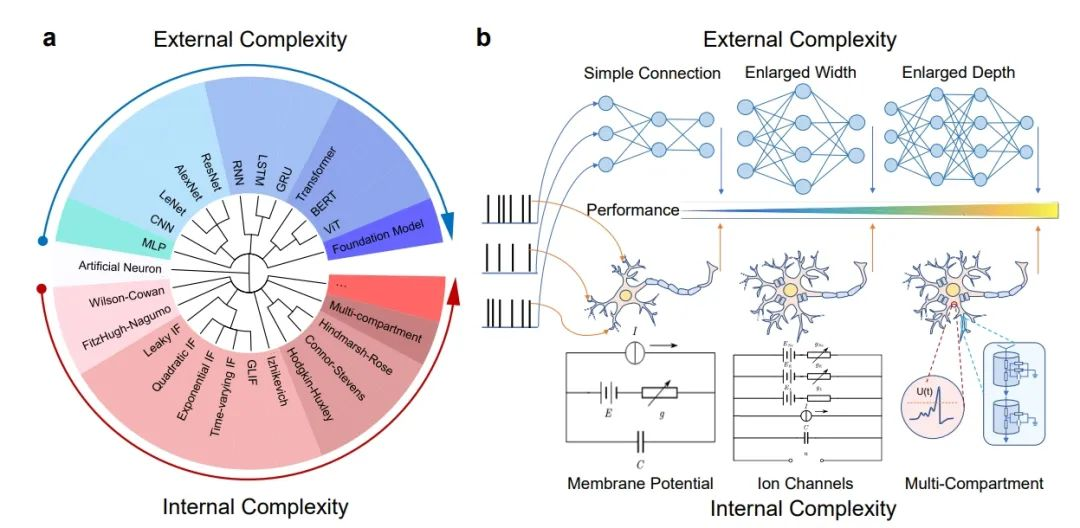

构建更加通用的人工智能,让模型具有更加广泛和通用的认知能力,是当前人工智能领域发展的重要目标。目前流行的大模型路径是基于尺度定律(Scaling Law)去构建更大、更深和更宽的神经网络,可称之为“基于外生复杂性”的通用智能实现方法。这一路径面临着计算资源及能源消耗难以为继、可解释性不足等问题。作为自然界最卓越的智能体,生物大脑成为人工智能研究最重要的参考对象。近年来,脑科学与人工智能的研究在相互促进中快速发展,尤其是类脑计算研究受到广泛关注。我院田永鸿教授团队联合中国科学院自动化研究所李国齐、徐波研究团队等借鉴大脑神经元复杂动力学特性,提出了“基于内生复杂性”的类脑神经元模型构建方法,改善了传统模型通过向外拓展规模带来的计算资源消耗问题,为有效利用神经科学发展人工智能提供了示例。相关研究论文8月16日在线发表于《自然·计算科学》(Nature Computational Science),该基础研究工作为推动自然智能与人工智能差距的弥合、降低AI碳足迹等科学领域提供了工具和框架。

图1.神经元和神经网络的内生复杂性与外部复杂性

编者注:

HH神经元模型,全称为Hodgkin-Huxley模型,由英国生理学家Alan Hodgkin和Andrew Huxley在1952年基于鱿鱼巨型轴突的电生理实验数据提出,用以描述神经脉冲的产生和传导,并因此获得了1963年的诺贝尔医学或生理学奖。该模型是一组描述神经元细胞膜电生理现象的非线性微分方程,直接反映了细胞膜上离子通道的开闭情况及其与膜电位变化之间的关系。HH模型是神经科学领域中的一个重要里程碑,它首次从分子水平上解释了动作电位的产生机制,为后续神经元电生理研究奠定了基础。LIF模型,全称为Leaky Integrate-and-Fire模型,Lapicque于1907年提出了Integrate-and-Fire(I&F)模型,输入脉冲可以集成到膜电位中,如果达到定义的阈值,则输出产生脉冲,膜电位回落至静息状态。LIF模型是I&F神经元模型的重要类型之一,增加了膜电位的泄漏。LIF模型简化了神经元动作电位过程,具有模拟神经元脉冲效率较高、计算成本较低等特性,成为大规模脉冲神经网络(SNN)中采用的主要神经元模型。

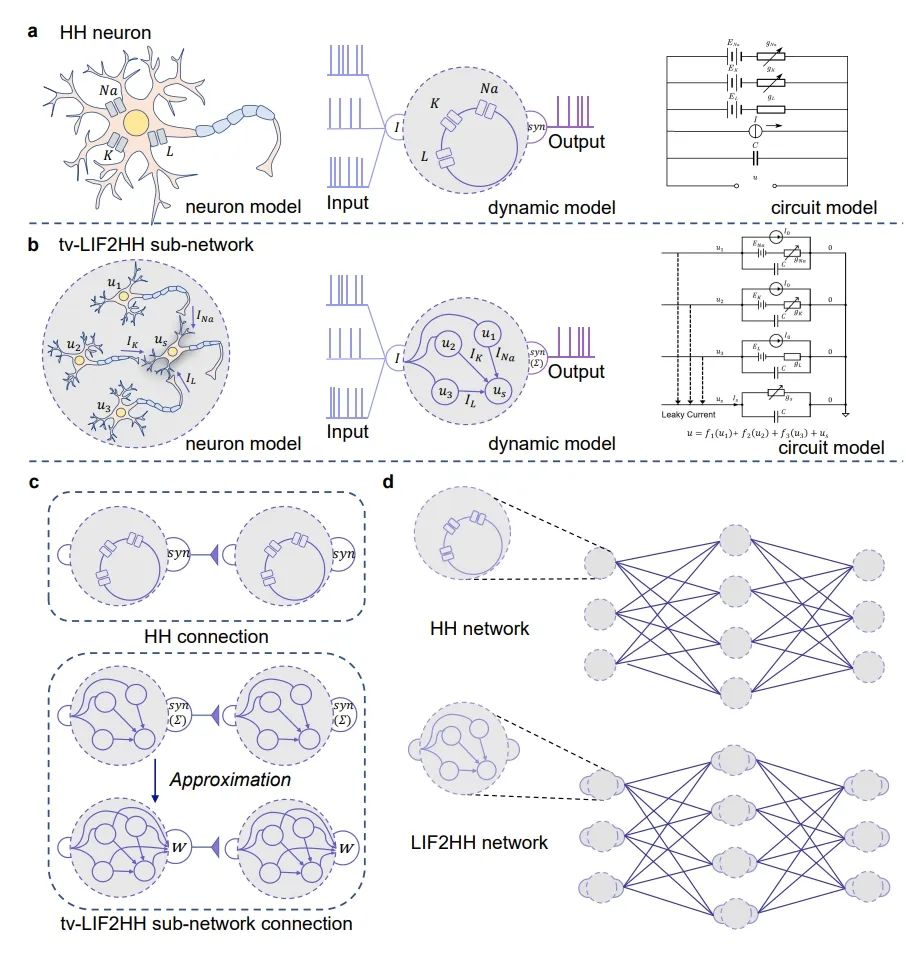

在类脑计算研究中,脉冲神经网络(SNN)占据核心地位,是最具有生物意义、最类似大脑运行机制的神经网络模型,被认为是新一代的神经网络。本研究首先展示了脉冲神经网络神经元LIF(Leaky Integrate and Fire)模型和HH(Hodgkin-Huxley)模型在动力学特性上存在等效性,进一步从理论上证明了HH神经元可以和四个具有特定连接结构的时变参数LIF神经元(tv-LIF)动力学特性等效。基于这种等效性,团队通过设计微架构提升计算单元的内生复杂性,使HH网络模型能够模拟更大规模LIF网络模型的动力学特性,在更小的网络架构上实现与之相似的计算功能。

进一步,团队将由四个tv-LIF神经元构建的“HH模型”(tv-LIF2HH)简化为s-LIF2HH模型,通过仿真实验验证了这种简化模型在捕捉复杂动力学行为方面的有效性。

图2.模型框架

实验结果表明HH网络模型和s-LIF2HH网络模型在表示能力和鲁棒性上具有相似的性能,验证了内生复杂性模型在处理复杂任务时的有效性和可靠性。同时,研究发现HH网络模型在计算资源消耗上更为高效,显著减少了内存和计算时间的使用,从而提高了整体的运算效率。研究团队通过信息瓶颈理论对上述研究结果进行了解释。

本研究为将神经科学的复杂动力学特性融入人工智能,为构筑人工智能与神经科学的桥梁提供了新的方法和理论支持,为实际应用中的AI模型优化和性能提升提供了可行的解决方案。目前,研究团队已开展对更大规模HH网络,以及具备更大内生复杂性的多分支多房室神经元的研究,有望进一步提升大模型的计算效率与任务处理能力,实现在实际应用场景中的快速落地。

该工作的共同通讯作者为中国科学院自动化所李国齐研究员、徐波研究员,我院田永鸿教授。共同一作是清华大学钱学森班的本科生何林轩(自动化所实习生),数理基科班本科生徐蕴辉(自动化所实习生),精仪系博士生何炜华和林逸晗。

编者注:

Nature Computational Science 期刊发表了来自UC Santa Cruz电气与计算机工程助理教授、开源类脑软件Snn Torch的核心贡献者Jason Eshraghian对此研究的评论:

“AI 研究更加贴近工程与应用,而神经科学的研究更加具有探索性。研究团队挑战了这一传统观点,并表明更详细且生物学上更真实的神经元模型可以推动深度学习取得更大进展。”

论文链接:

https://www.nature.com/articles/s43588-024-00674-9

评论链接:

https://www.nature.com/articles/s43588-024-00677-6

【拓展阅读】

探讨如何从大脑中获得灵感、使人工智能更加高效、弥合自然智能与人工智能之间的差距并取长补短、降低AI的碳足迹是生物学、认知科学、信息学等学科进行交叉与融合的重要研究内容,提升SNN响应外部环境变化的实时性和自适应性,降低计算和通信的能耗,促进大规模SNN新模型的构建和部署,支持实现高可解释性、强泛化能力的人工智能,将对拓展人工智能的更广阔应用前景注入发展动能。

Nature Computational Science由Springer Nature于2021年推出,专注于开发和使用计算技术和数学模型,并将其应用于解决各个科学领域的复杂问题。该期刊的主要目标是促进多学科研究和新计算技术的跨学科应用,既刊登基础研究,也刊登应用研究,既刊登有助于推动科学研究的突破性算法、工具和框架,也刊登以新颖方式利用计算能力发现新见解和对挑战性现实问题的解决方案。通过这种方式,该期刊创造了一个独特的环境,让不同学科的人员汇聚一堂,共同讨论计算科学的最新进展。

文字编校:Lilly